Nga telefonatat robotike te klonet e zërit, gjeneruesi AI (inteligjencë artificiale) po i lejon aktorët keqdashës të përhapin me lehtësi dezinformata

Nga Dymples Leong për Lowy Institute, përshtatur në shqip nga Rruga Press

Kompania e inteligjencës artificiale OpenAI prezantoi kohët e fundit Voice Engine, një gjenerator të të folurit me tingull natyral që përdor tekst dhe një mostër audio 15 sekondash për të krijuar një imitim “emocional dhe realist” të altoparlantit origjinal.

OpenAI nuk e ka publikuar ende Voice Engine për publikun, duke përmendur shqetësimet në lidhje me abuzimin e mundshëm të inteligjencës artificiale gjeneruese (AI) – veçanërisht për të prodhuar falsifikime audio – të cilat mund të kontribuojnë në dezinformim, veçanërisht gjatë zgjedhjeve.

Deepfake-t audio dhe përdorimet e tyre

Depfake audio krijohen duke përdorur teknika të të mësuarit të thellë në të cilat grupe të mëdha të dhënash të mostrave audio përdoren për modelet e AI për të mësuar karakteristikat e të folurit njerëzor për të prodhuar audio realiste. Deepfake-t audio mund të gjenerohen në dy mënyra: tekst në të folur (teksti konvertohet në audio) dhe fjalim në të folur (një regjistrim zëri i ngarkuar sintetizohet si zëri i synuar).

Deepfake-t audio janë përdorur në mashtrimet financiare të aktivizuara në internet, ku mashtruesit imitojnë klientët e bankave për të autorizuar transaksione. E njëjta teknologji po përdoret gjithnjë e më shumë për të përhapur dezinformimin. Në mediat sociale kanë qarkulluar disa fake audio që përpiqen të imitojnë zërat e politikanëve. Në vitin 2023, klipet audio të krijuara artificialisht të liderit të Laburistëve në Mbretërinë e Bashkuar, Keir Starmer, dyshohet se e shfaqnin atë duke qortuar stafin e partisë. Ndërsa kontrolluesit e fakteve përcaktuan se audioja ishte e rreme, ajo tejkaloi 1.5 milion klikime në X (dikur Twitter).

Në Indi, klonimi me zë i fëmijëve është përdorur për të mashtruar prindërit për të transferuar para. Në Singapor, videot e rreme që përmbajnë klone zanore të politikanëve si kryeministri dhe zëvendëskryeministri janë përdorur në mashtrime kibernetike.

Bum marketingu

Çdokush mund të gjenerojë një audio të rreme. Ato janë më të lehta dhe më të lira për t’u bërë se sa video të rreme dhe më të thjeshta për t’u shpërndarë në mediat sociale dhe platformat e mesazheve.

Me përparimet në teknologji, nevojiten vetëm një ose dy minuta audio për të gjeneruar një regjistrim bindës “deepfake”. Më shumë klone zanore profesionale kërkojnë pagesë, por shumat nuk janë ndaluese. Motori i zërit i OpenAI ka reduktuar numrin e sekondave audio të nevojshme për të krijuar një regjistrim realist.

Komercializimi i teknologjisë audio deepfake ka lulëzuar vitet e fundit. Kompani të tilla si ElevenLabs ofrojnë shërbime për të krijuar kopje sintetike të zërave, për të gjeneruar të folur në 29 gjuhë dhe për të përputhur thekse të zgjedhjes së dikujt.

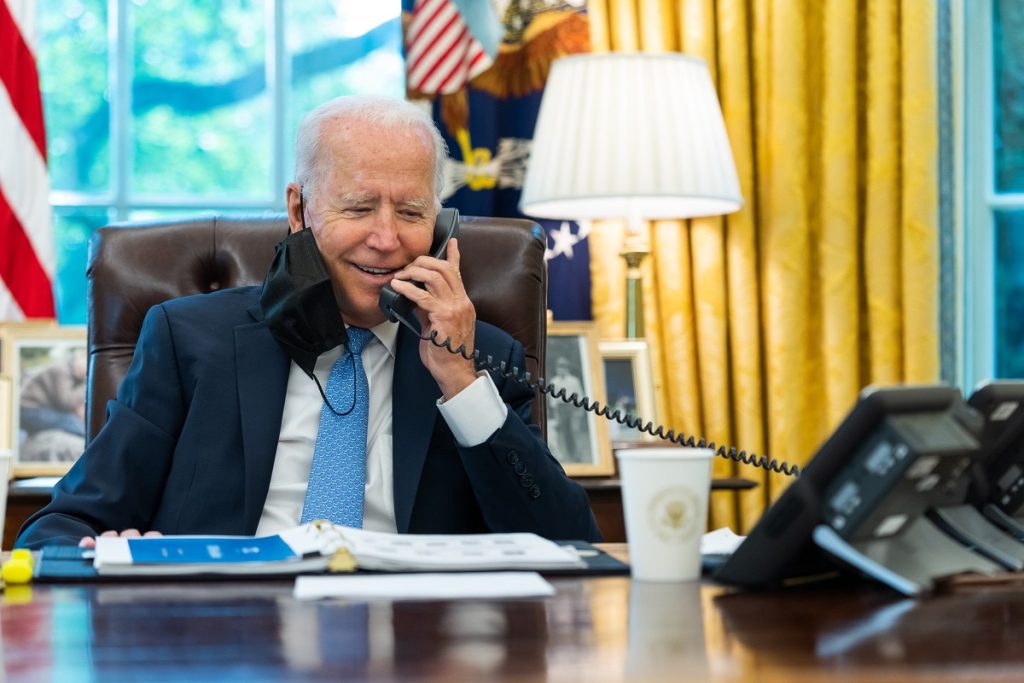

Vitet e fundit ka pasur një rritje të depfakeve politike që synojnë proceset zgjedhore, me synimin për të mbjellë mosmarrëveshje dhe konfuzion. Deepfakes audio po përdoren në prag të zgjedhjeve në Indi. Një audio e mundësuar nga AI e Presidentit të SHBA Joe Biden u përdor në një thirrje robotike që synonte banorët e regjistruar demokratë në New Hampshire përpara FPrimareve Demokratike në janar 2024. Ndërsa thirrja robotike u konsiderua e rreme, ajo shërbeu për të rritur ndërgjegjësimin e publikut për rreziqet e mundshme të klonimit të zërit të aktivizuar me AI.

Ditë përpara zgjedhjeve parlamentare në Sllovaki, regjistrimet audio të rrejshme që supozohet se shfaqnin biseda midis një politikani kryesor dhe një gazetari që diskutonin tema të tilla si manipulimi i votave u bënë virale, duke përçarë opinionin publik pavarësisht fakteve që verifikonin se regjistrimet ishin të rreme dhe të manipuluara – bisedat nuk ndodhën kurrë. Ekspertët besojnë se regjistrimet mund të kenë ndikuar në rezultatin e zgjedhjeve.

Në Shtetet e Bashkuara, zyrtarët e zgjedhjeve shtetërore janë të shqetësuar për shënjestrimin e klonimit të zërit, i cili mund të përdoret për të shpallur me keqdashje rezultate të rreme të zgjedhjeve.

Deepfakes audio mund të përdoren gjithashtu për të mbjellë mosmarrëveshje dhe për të nxitur dhunën. Një audio deepfake e kryetarit të bashkisë së Londrës, Sadiq Khan, duke u zhdukur në fundjavën e Kujtesës dhe duke bërë thirrje për marshime pro-palestineze në Londër, u manipulua për t’i ngjajtur një regjistrimi sekret audio. Ajo u bë virale në mediat sociale dhe çoi në komente urrejtjeje drejtuar Khan.

Këto përdorime të inteligjencës artificiale gjeneruese kanë potencial real për të ndikuar në opinionin publik dhe të mbingarkojnë dezinformata, duke e lejuar atë të përhapet me shpejtësi në mediat sociale dhe platformat e mesazheve.

Zgjidhjet janë në punë e sipër

Deepfake audio përmbajnë më pak shenja të dukshme manipulimi sesa videot ose imazhet e rrejshme dhe nuk zbulohen lehtësisht pa ekspertizë teknike.

Kompania e softuerit të sigurisë kompjuterike McAfee njoftoi së fundmi Projektin Mockingbird për të zbuluar dhe ekspozuar audion e ndryshuar në video. Kompanitë që ofrojnë shërbime për gjenerimin e zërit të AI kanë marrë gjithashtu masa për të siguruar që sistemet e tyre të mund të identifikojnë audion e ndryshuar. Filigrani i audios së gjeneruar nga kompani të tilla mund të kontribuojë në një farë mënyre për të promovuar monitorimin proaktiv të audios fallco dhe mënyrën se si ato përdoren.

Në frontin legjislativ, ka pasur një thirrje në rritje për veprim globalisht. Shtetet e Bashkuara janë zotuar të përpiqen të rregullojnë falsifikimet audio të përdorura në zgjedhje, për shembull, duke ndaluar thirrjet robotike gjatë fushatave.

Theksi duhet të vihet në reagimin e shpejtë për të hedhur poshtë dezinformatat dhe dezinformatat e përhapura nga falsifikimet audio. Dhënia e më shumë burimeve gazetarëve dhe kontrolluesve të fakteve për të shfrytëzuar ekspertizën e tyre kolektive të subjekteve do të shkonte shumë drejt çmitizimit të falsifikimeve të thella dhe ekspozimit të përdorimit të AI nga aktorë keqdashës për të gjeneruar përmbajtje mashtruese.

Rruga Press